词库的作用 SEO高端操作手法之建立词库

关键字

1)网页内容构筑

关键字作者 透过单词推卸责任(或非) 5118显景词:https://ci.5118.com/1b49a5d8/ 爱站显景词:https://ci.aizhan.com/8d5a94b1/ 有关搜寻(包涵单词的)轮循 沙莱县框(包涵单词的)轮循 官方站点关键字

拷贝市场竞争度:官方站点>5118&爱站>有关搜寻&沙莱县灵活性:官方站点&5118&爱站>有关搜寻&沙莱县或非关键字,市场竞争度非常大

透过中文网站推卸责任(非或非)

5118中文网站网页内容:https://www.5118.com/seo/baidupc/www.1688.com

爱站中文网站网页内容:https://baidurank.aizhan.com/baidu/1688.com/

结点市场竞争者中文网站世界地图:

tag页、专题讲座页…sitemap

/tag/1/ /tag/2/ /tag/3/

…跟应用领域相关,但是不是明晰的单词

进行分类 透过单词开拓的 找寻甄选前提

甄选前提,能做为中文网站版块或甄选项

找寻搜寻市场需求

有找沟通交流群的,有找新商品的,有问某一商品靠不可信赖的…

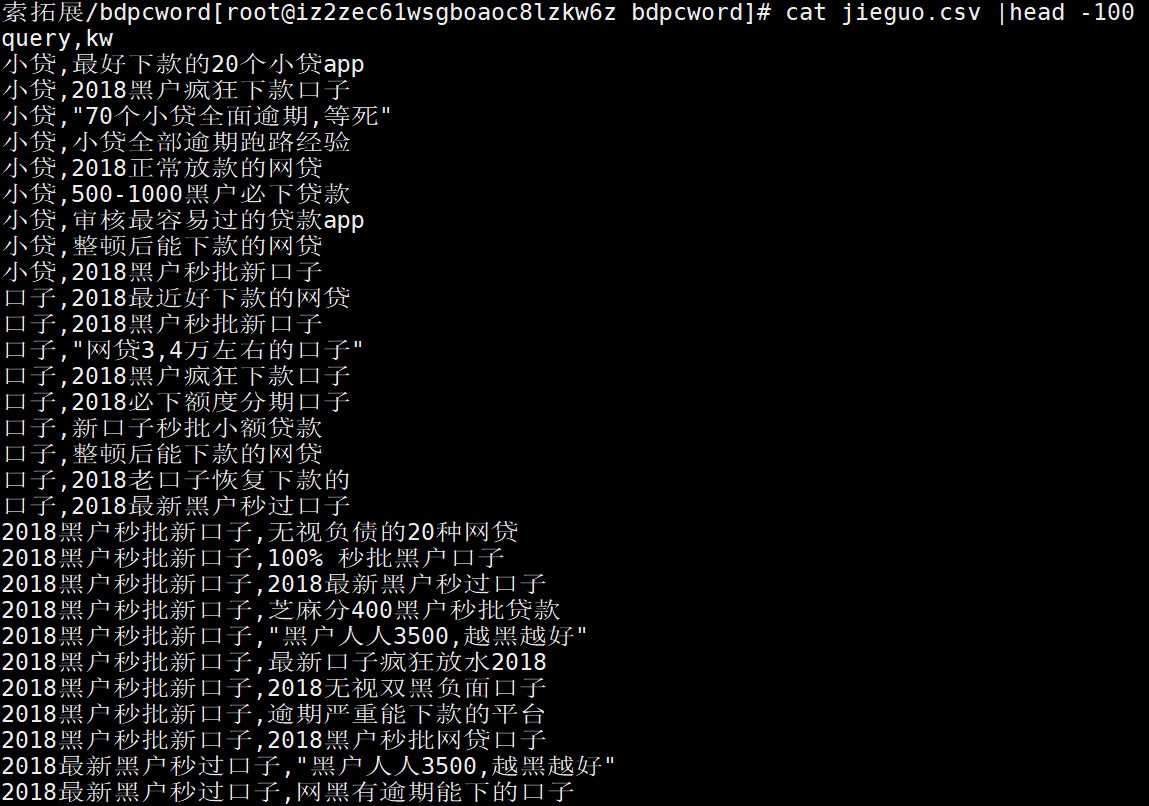

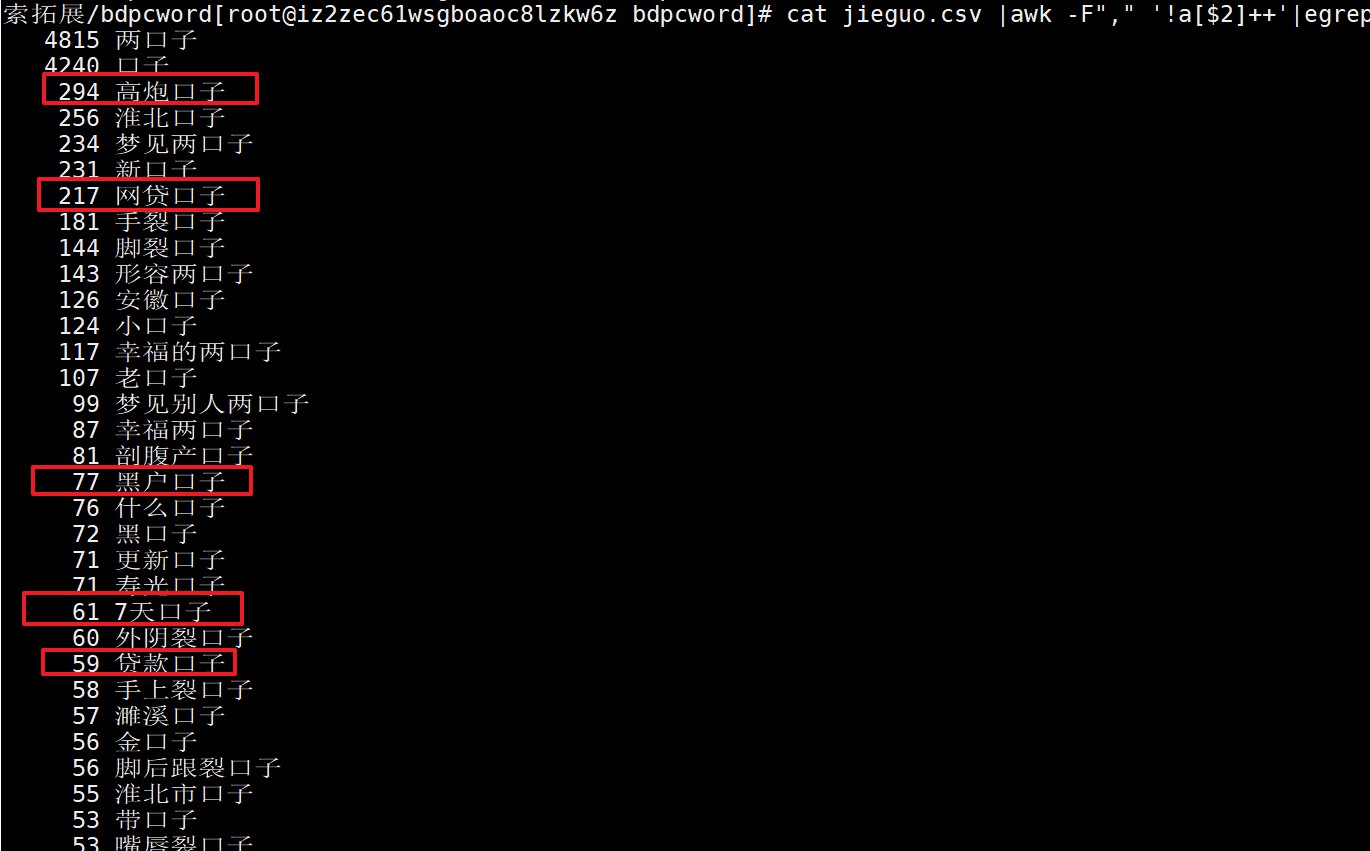

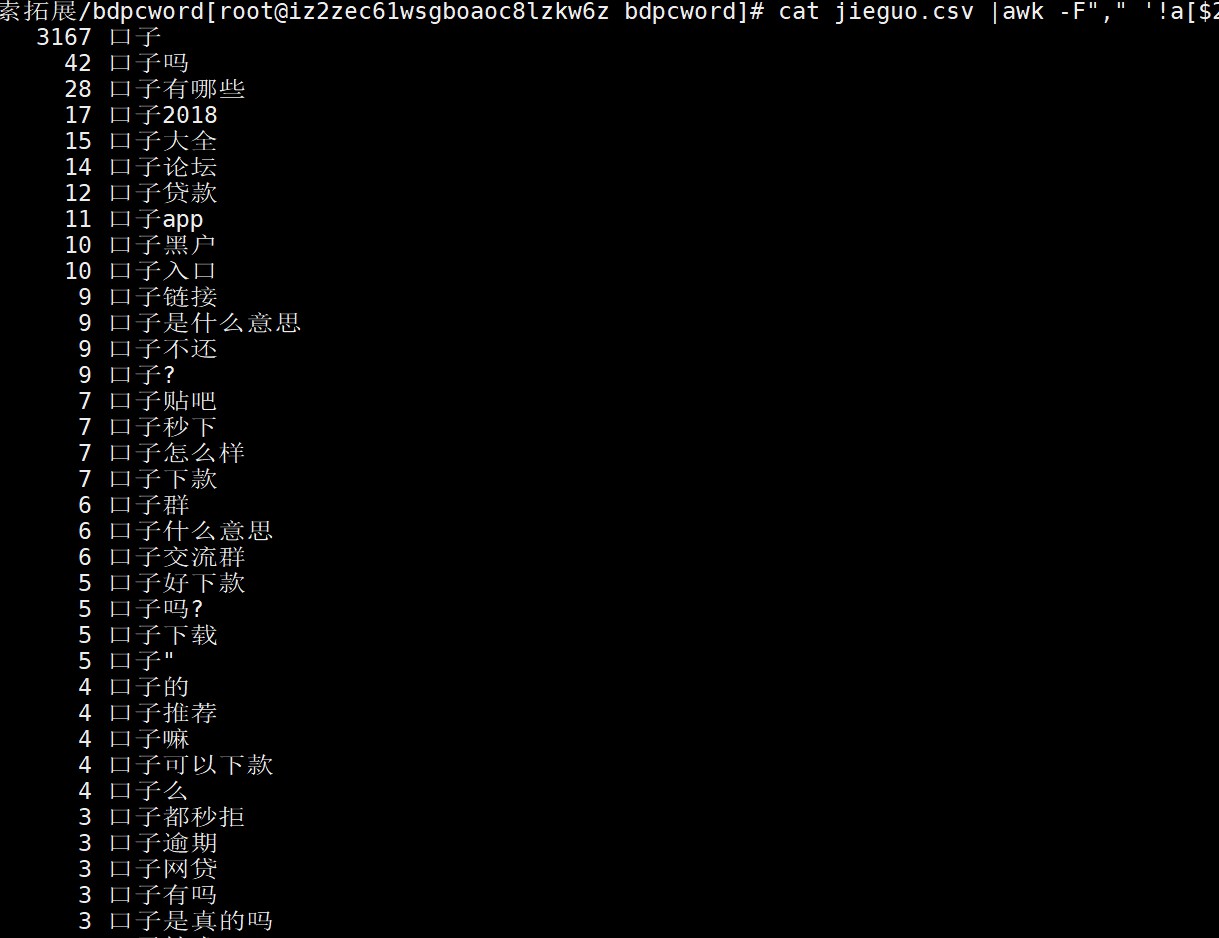

依照甄选条件和搜寻市场需求,大批量聚合大批词拷贝{贷款商品}+口子+怎么样/是真的吗/入口/链接/贴吧..{贷款类型}+口子+有哪些/大全...

透过中文网站开拓的

过滤出垃圾词

与本站内容完全不有关的

不符合社会主义核心价值观的

重复的

过滤方法

与本站内容完全不有关的最简单的办法,透过搜寻解决。每个词,搜寻整站内容,如果没有搜寻结果,则与本站内容不有关

不符合社会主义核心价值观的命中黑名单

重复的删掉停止词后,再分词后,词项完全一致的,保留一个

拷贝原始词:北京公积金提取前提北京市公积金提取前提北京公积金的提取条件公积金北京提取前提停止词(stopword.txt):的、{地区前缀}市...删除停止词:北京公积金提取前提北京公积金提取前提北京公积金提取前提公积金北京提取前提分词获取词项(jieba模块实现分词):[北京,公积金,提取,前提][北京,公积金,提取,前提][北京,公积金,提取,前提][公积金,北京,提取,前提]>>>四个词的词项完全一致,保留一个词>>>保留:北京公积金提取前提

进行分类

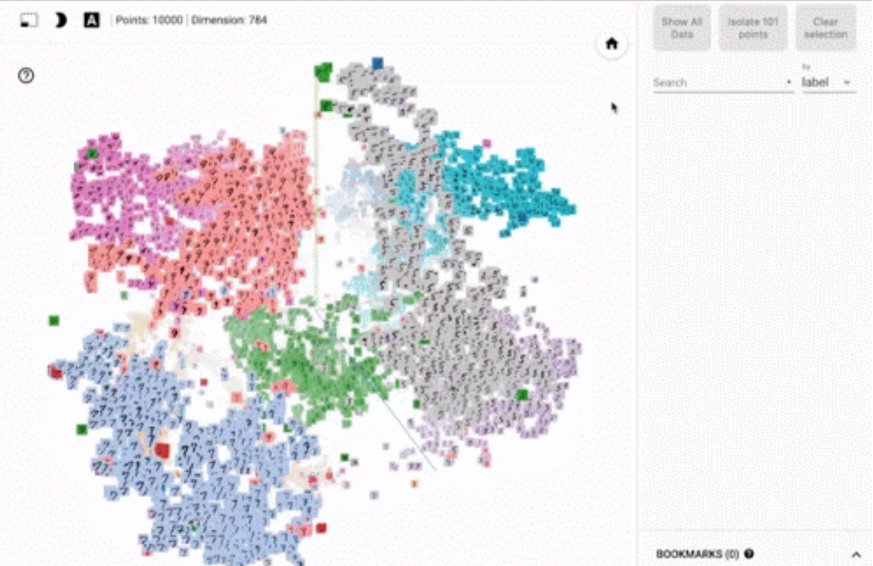

词向量http://ai.baidu.com/tech/nlp/word_embedding

机器学习:tensorflow

透过搜寻 中文网站每个版块下,随机抽取几千篇文章标题 依次给每个版块的文章标题,创建索引 用开拓词依次去搜寻,每个版块标题的索引,并记录搜寻结果数量 将该关键字,归类到搜寻结果数最大的版块下拷贝比如:1)中文网站有A、B、C、D四个版块,各抽取5000篇文章,创建4个索引2)开拓关键字a,依次去搜寻四个版块文章的索引3)ABCD四个版块的搜寻结果数,依次是:90、80、56、1094)则开拓关键字a,归类到栏目D下

打标签

文章标签:http://ai.baidu.com/tech/nlp_apply/topictagger

文章进行分类:http://ai.baidu.com/tech/nlp_apply/doctagger

2)关键字布局

拷贝解决网页"塞什么词"以及"塞多少"的问题,进一步解决,网页相似性的问题

2.1)TF-IDF计算

TF = 某一词在文档中出现的次数 / 文档的长度

拷贝关键字:"黑户口子"目标页:http://www.pcben.com/news/gonglue/11835.html>>>词项:[黑户,口子]>>>文档字数:2104>>>[黑户]出现次数:19>>>[口子]出现次数:49

TF(黑户)=19/2014=0.009

TF(口子)=49/2104=0.023

IDF = log( 搜寻引擎文档总数 / 出现某一词的文档总数 )

PS:log以2为底

拷贝搜寻引擎文档总数:100000000[黑户]文档总数:21400000[口子]文档总数:36500000

IDF(黑户)= log(100000000/21400000)=2.22

IDF(口子)= log(100000000/36500000)=1.45[黑户]的重要性是[口子]的1.5倍>>>网页多出现[黑户],能提高与[黑户口子]的有关性

TF-IDF(黑户口子)= TF(黑户)*IDF(黑户)+ TF(口子)*IDF(口子)=0.009×2.22+0.023×1.45=0.05

2.2)TF-IDF的意义

网页不见得内容越多越好。若布局不当,内容越多反而会稀释TF(keyword)的分值,从而降低这个词与这个网页的有关性

IDF本质是一个词项的权重,降低文档中高频关键字的权重。所以网页中,玩命塞完整的关键字不见得好,但要多塞这个关键字中IDF最高的词项拷贝Case:[北京百度区块链工程师工资]的网页,若添加内链模块,以下哪个规则,对提升有关性,可能效果最好?词项:北京、百度、区块链、工程师、工资

A.调用北京地区,10个随机职位的工资链接(降低相似性,甚至降低排名)

B.调用北京地区,30个百度职位的工资链接(比A严重,降低相似性,降低排名)

C.调用北京地区,10个区块链工程师的工资链接(get)

D.调用北京地区,20个区块链工程师的招聘链接(get)

2.3)BM25计算

TF-IDF存在明显漏洞,因为SEO能透过 [缩减页面内容量] 和 [堆砌IDF高的词项] 来拉高关键字与网页的有关性

因此现在采用的都是BM25算法,在TF-IDF基础上,添加了3个参数:

常量K:用来限制TF值的增长极限,TF值永远在 [0 ~ K+1] 之间 参数L:文档长度与平均长度的比值,如果文档长度是平均长度的2倍,则L=2 常数b:用来规定L对评分的影响有多大Elasticsearch里,K默认1.2,b默认0.75

$\text{公式} = 权重(IDF)×有关性 = \sum_{i=1}^n\text{IDF}(keyword)\cdot\left[\frac{TF(keyword)\cdot\left(k+1\right)}{TF(keyword) + k\cdot\left(1-b+b\cdot\frac{当前文档的字数}{整个文档库的平均字数}\right)}\right]$

2.4)BM25的意义 增加了文档长度对有关性的影响。文档越短,有关性会比用TF计算的值更低,减少透过 [缩减页面内容量] 对有关性计算的干扰 增加了对TF极限值的限制,减少透过 [堆砌IDF高的词项] 对有关性计算的影响 只是影响而已,[缩减页面内容量] 和 [堆砌IDF高的词项] 还是有用的,注意尺度 BM25同样促进作用于title